2024年诺贝尔物理学奖:一次思维的模仿

机器能思考吗?这个问题很模糊,尤其是因为我们没有对“思考”的正确定义。如果定义过分,任何东西——即使是一个简单的恒温器——都可能被指责为具有思考能力。如果定义过狭隘,甚至一些人类也可能被剥夺这种能力。

然而,自从计算机出现以来,人们一直在问,计算机是否有朝一日会开始思考。艾达·洛夫莱斯是第一批认真考虑这种可能性的人之一,她认为这不太可能。她在 19 世纪 30 年代写道,计算机不能“创造任何东西”,只会做“我们知道如何命令的任何事情”。她认为,机器只能做它们被编程要做的事情,而这不需要思考。

但后来有人问,如果我们给计算机编程,让它学习,结果会怎样?它能学会自我推理,甚至自我编程吗?如果我们能做到这一点,计算机是否能够学会创造,甚至产生一些原创思想?那么我们是否可以说,计算机——仅仅是一个指令接受者——已经学会了思考?

伟大的艾伦·图灵在 20 世纪 40 年代提出了这个问题,并就此发表了一篇著名的论文。他指出,操作员可以非常轻松地将想法注入机器并观察其反应。但他表示,这就像听到锤子敲击钢琴弦:反应很快就会消失,就像琴弦很快就会沉寂一样。

这样的机器很难说是会思考的。但他接着说,思考可能更像一个处于临界水平以下的原子堆。原子堆在无人看管的情况下是惰性的,非常安全。如果向原子堆发射一个中子,它会在短时间内引发一阵扰动。但如果将原子堆的体积稍微增大一点,中子就会引发不同的反应:扰动会传播和倍增,如果不加以控制,原子堆将在巨大的能量爆炸中被摧毁。

他沉思道,智能可能就是这样运作的。组装一台足够复杂的机器,一个想法可能更像一个中子而不是一把锤子。那个单一的音符不会消失,而是可能爆发成一场思想和创造力的交响乐。图灵推断,人类的大脑一定高于这个临界水平,而动物的大脑则低于这个水平。

他总结道,如果我们能组装一台足够复杂的机器,那么我们也能对它进行编程,让它学习。一旦机器能够学习,它就能改变自己的操作规则,根据它所获取的信息进行调整,从而产生意想不到的输出。就像孩子会根据指导改变自己的行为一样,一台会学习的机器也可能调整自己的反应。

这样的计算机与洛夫莱斯设想的严格遵循规则的计算机大不相同。学习型计算机的行为方式神秘莫测,任何操作员都无法了解其内部模型和规则。它可能会犯错,就像我们一样,学习不正确的世界规则。毕竟,图灵写道,任何学到的东西都可以被忘记,没有什么是百分之百确定的。

他认为这可能需要五十年才能实现,但这样一台奇怪的机器肯定是可能的。毕竟,如果我们的大脑能够学习、思考和做梦,为什么我们不能制造一台机器来至少模仿这一点呢?

ChatGPT 之路

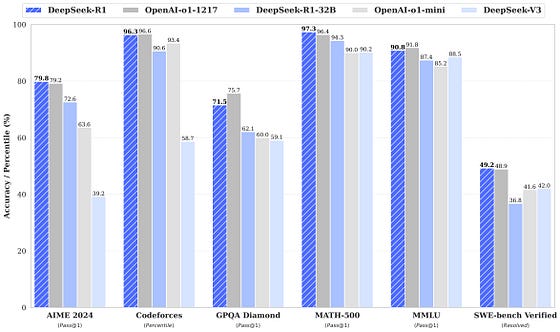

图灵略显乐观。但现在可以说,在他开创性的论文发表 70 年后,他的愿景已经变成了现实。现代“大型语言模型”(其中最著名的例子是 GPT-4)与图灵对学习机器的愿景非常契合。它们不遵循程序员设定的规则,而是通过解析大量数据来构建自己的规则。它们的行为方式神秘,会产生幻觉,在交谈中,可以模仿人类。

2024 年诺贝尔物理学奖就是为表彰这些机器的发展做出的贡献而颁发的。当然,人们可以批评这一决定。图灵不是物理学家,也永远不会把自己描述成物理学家,也不会把他的领域描述成物理学的一部分。但一些导致大型语言模型发展的突破依赖于物理学家开发的工具,因此诺贝尔委员会选择授予他这个奖项。

两位获奖者:约翰·霍普菲尔德和杰弗里·辛顿。他们的想法帮助设计出计算机既能记忆信息又能从中找出规律的方法。后来,其他人利用这些方法制造出了能够学习甚至思考的计算机。

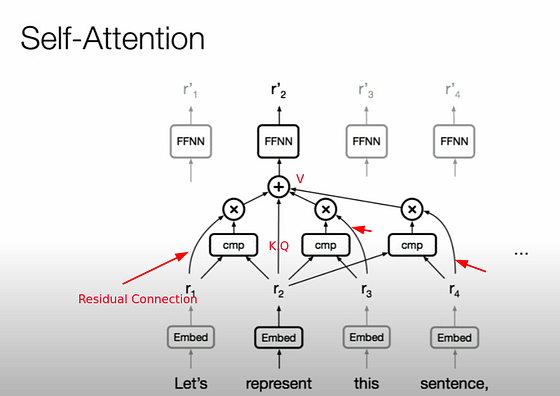

然而,在研究它们做了什么之前,我们应该先回顾几十年前,看看人类大脑的首次模仿。我们现在知道,这是基于被称为神经元的细胞。每个神经元都能够通过突触网络传输信号并与其他神经元通信。单个神经元无法做很多事情,但作为更大网络的一部分,它们可以产生语言、记忆和意识。

为了在计算机上模拟这一过程,研究人员构建了神经网络系统。神经元可以用赋值的节点来表示,它们可以通过突触连接起来。就像大脑一样,这些连接可以加强或减弱,从而使网络随着时间的推移而发展,从理论上讲,这就是学习。

尽管这些网络最早是在 20 世纪 50 年代创建的,但直到 20 世纪 80 年代,研究人员才真正弄清楚如何使用它们。当时的一个研究领域是记忆,特别是神经元如何协同工作以形成和重建记忆。霍普菲尔德利用最初为模拟磁体中原子自旋而建立的方程式,找到了一种数学方法,从而使神经网络不仅可以存储信息,还可以存储多条信息,然后根据需要检索它们。

在他的方法下,网络几乎就像创造了一个能量景观。记忆在景观中形成低点,有点像周围群山之间的山谷。要检索记忆,需要输入 – 例如,可能是原始数据的片段。网络将这个片段放在景观中,然后让它“滚动”到最近的山谷。从那里,网络可以重建原始数据,从而“记住”它以前见过的东西。

然而,单靠记忆是不够的。要做到这一点,机器还必须能够将记忆联系在一起,并将它们归类为更广泛的群体。例如,我们可以说一个物体是一只猫,即使我们以前没有见过这只猫。根据我们见过的所有其他猫,我们的大脑天生就对“猫”有概念——有四条腿、一条尾巴和尖耳朵。

辛顿的工作基于研究大量粒子统计数据的技术,他找到了在神经网络中实现这一目标的方法。他发明了一种称为玻尔兹曼机的东西,这是一种可以学习模式并分配概率的系统。因此,经过一段时间的训练后,它能够识别物体(例如猫),并据此对其进行分类。

这两组工作都已有几十年的历史,如今已得到完善和发展。但它们在开发机器学习方法方面都发挥了重要作用,从而构建了如今如此令人兴奋的大型语言模型。它们无疑是图灵很久以前设想的机器的关键步骤。

路途危险吗?

图灵在 1950 年写道,机器“最终可能会在所有纯智力领域与人类竞争”。他指出,国际象棋当时是一个未解难题,但现在机器在这方面远远超过人类。今天的模型,包括 ChatGPT-4,已经通过了律师资格考试,参加了数学奥林匹克竞赛并创作了艺术作品。它们很快就会变得比我们聪明得多吗?

这样的前景似乎是一个技术圣杯。智能机器可以加速技术发展,从而为核聚变、星际飞行和延长寿命开辟道路。然而,正如杰弗里·辛顿去年警告的那样,它们也可能让我们陷入严重危险。

在 2010 年代的大部分时间里,Hinton 都在谷歌工作,帮助这家科技巨头开发人工智能系统。但在 2023 年,他辞去了那份工作,并接受了《纽约时报》的一次令人恐惧的采访。他当时说,他对自己一生的工作感到后悔,并担心它可能会在未来被用于邪恶之事。他说,很难“看到如何阻止坏人利用它做坏事”。他说,“很难看出如何阻止坏人利用它做坏事。”

一个显而易见的问题是虚假信息的兴起。互联网已经退化,其所包含的信息也已遭到破坏。现在,人们可以制造虚假形象,让教皇穿上巴黎世家的衣服,或者将一位新兴政客描绘成罪犯。这种趋势令人担忧:毕竟,当谎言变得如此廉价时,还有什么可信的呢?

更可怕的是创造出我们无法控制的超级智能的风险。这种事情显然对人类来说是危险的——事实上,正是我们自己的智慧让我们主宰了地球。那些更聪明、能力可能无限的生物会选择做什么,我们无法知晓。

辛顿说得对。这是一条危险的道路。我们正在创造一种我们并不完全理解——也不可能完全理解的东西。有人将它与原子弹作比较,似乎很贴切。毕竟,它是一项塑造了上个世纪的技术,它带来了自我毁灭的威胁,负责任的物理学家们也努力为它辩护。

据说奥本海默曾称原子弹“在技术上是绝妙的”,这是一个不容忽视的巨大挑战。然而,原子弹的后果让他感到恐惧。他后来告诉杜鲁门总统:“我手上沾满了鲜血”,然后试图确保这种武器永远不会再被使用。

一切都太迟了。物理学家们发明的技术落入了政客和将军之手。欣顿担心自己也做了同样的事情,而现在——这一次落入了硅谷亿万富翁之手——人工智能将被证明是弊大于利。如果真是这样,物理学研究可能给人类带来了另一场生存危机。

模仿游戏

1950 年,图灵提出了一个测试,用于测试会思考的机器。他认为,如果机器能够完美地模仿人类,以至于面试官无法区分机器和人类,那么我们就可以断定机器能够思考。几十年来,这种“模仿游戏”一直被视为人工智能的终极目标。

如今,毫无疑问 ChatGPT 赢得了这场游戏。其他日益复杂的模型也取得了胜利。但它们真的像图灵所相信的那样会思考吗?如今很少有人相信它们会思考。那么,它们只是执行极其复杂算法的巨型机器吗?算法在何时会变成思考,模仿又何时会变成现实?如果真的会,我们该如何判断?

如今,那些讨论这个话题的人听起来更像洛夫莱斯而不是图灵。他们说,语言模型只是统计模型。它们只是遵循指令,无法推理,无法思考。但它们可以学习,正如图灵所预言的那样,它们可以像孩子一样独立形成世界模型。随着时间的推移,它们可能也会学会推理。

事实上,许多最初反对思考机器概念的言论已经被远远超越。目标也因此发生了变化——如果我们现在说,一台机器可以做 X、Y 或 Z,那么就可以说它在思考。但这些标记也肯定会被超越。然后目标会再次改变吗?我们是否害怕承认一台机器实际上可以思考,以及这将带来的所有后果?

图灵的观点其实是,这无关紧要。“思想”这个概念太模糊了,我们应该把重点放在机器的能力上。如果一台机器能够像会思考一样行动,那么我们就可以说它在思考,就这样吧。毕竟,我们不会争论潜艇是否会游泳,或者汽车是否会跑。重要的是结果,而不是方法。

在这方面,图灵提出的、Hinton 和 Hopfield 帮助建造的机器显然取得了成功。它们可能不是真正思考或有意识的,但它们至少已经提供了对它们的公平模仿。